(文/ MacGregor Campbell)据家里人说,我妻子的祖母克莉欧(Cleo)有一次用鼠标闹出了笑话。那是她第一次坐下来学习使用计算机,她的4个儿子围在她身旁指指点点。一个说:“把指针移到左边。”她把鼠标移到了左边。“再移到右边。”一点问题没有。“再把指针移到上方。”克莉欧把鼠标抬离了桌面,却惊讶地发现光标并没有随之而动。

听上去很傻,但她的动作是天性使然。为了让计算机明白我们的意图,我们已经把出自本能的身体运动压缩到了二维的鼠标垫或者触摸屏上。这一点即将发生改变。

从公共资讯站到你的起居室,从今年开始,我们日常使用的计算机将开始以前所未有的精确度理解我们的手势词汇,哪怕极为精细的手指动作也不会错过。这将如何改变我们与数字世界交互的方式?一些倡导者声称,鼠标和键盘将会遭到淘汰。这不过是危言耸听。手势计算带来的影响当中,我们自身将被如何改变才是更有趣的部分:从我们可能会被要求学习的种种新型“手语”,到一种被称为“大猩猩臂”的病痛。反过来,我们的行为又将决定技术的演进方向。对于我们漫游数字空间的方式,是时候跟旧观念说再见了。

最早能够识别人类手势的计算机,出现于20世纪70年代。那时候,研究者把指挥棒或者可穿戴式加速计装到了人身上。低下的分辨率将这些技术扼杀在了起步阶段。不过有限的几种二维肢体语言,还是得到了个人计算机的接纳:使用鼠标拖拽滚动条或者双击桌面图标,需要的就是手和臂的肢体运动,而不是键入代码。多点触控屏幕在我们的手势词典中增加了更多的动作:比如,我们学会了在屏幕上分开两根手指来放大照片或者地图。

然而直到最近,计算机仍然看不到我们的大多数手势和身体语言。尽管拜微软Kinect这样的深度感知技术所赐,手臂、腿和躯干的位置都能够用来控制视频游戏,但我们的计算机、电视机和其他设备大体上还停留在更加传统的控制方式上。

微软的Kinect让玩家能够用手臂、腿和躯干的位置来控制视频游戏。图片来源:blogcdn.com

微软的Kinect让玩家能够用手臂、腿和躯干的位置来控制视频游戏。图片来源:blogcdn.com

不过,就在今年7月,美国旧金山的Leap Motion公司将推出一种被许多人寄予了厚望的设备。这种售价80美元的盒子可以插接到大多数计算机上,追踪极为精细的手部和手指运动。该公司并未披露具体的工作原理,但是借助红外和可见光摄像机,以及设计巧妙的软件,Leap能够侦测到半米见方的空间中精细度达1毫米以下的手势。Leap Motion旗下名为Airspace的应用商店也会同时上线,将提供包括从音乐到绘画程序在内的一些列手势控制软件。

读取信号

很多人认为,高精度手势探测的作用范围用不了多久就会扩展到整个房间。举例来说,美国麻省理工学院媒体实验室的扬·杰式卡(Jan Zizka)和阿历克斯·奥尔沃尔(Alex Olwal)开发了SpeckleSense。这种设备利用激光光斑,即相同频率的光相互干涉时产生的精细图案,来追踪运动,精密程度和作用范围都远超Kinect之类的技术。

于是忽然之间,计算机能够理解的手势语言的精确程度,即将出现大幅提升。“双手脱离了设备的束缚,于是那些原本现成的手势一下子有了用武之地,”美国华盛顿大学的人机交互研究人员雅各布·沃布洛克(Jacob Wobbrock)说,“毫无疑问,各式各样的手势词汇从今往后将更加深入计算机使用者的内心。”

那么,在接下来的几年里,我们可能会学到什么样的三维手势呢?毕竟,在触摸屏上分开手指的手势,是必须通过学习才能掌握的,苹果公司甚至为这个手势申请了专利。如果是10年前,你在别人面前做这个动作,他们不会明白这是什么意思。未来,我们也将使用类似的手部动作来触发特定的命令吗?

Leap预置了识别几种基本手势的能力。比如一根手指做出敲击动作的“击键”手势,可能会被用来调出屏幕键盘。独立应用开发商正在训练它识别他们自己定义的手势,比如“翘拇指”的动作,已经被一些人用来在Facebook的帖子上点“赞”。

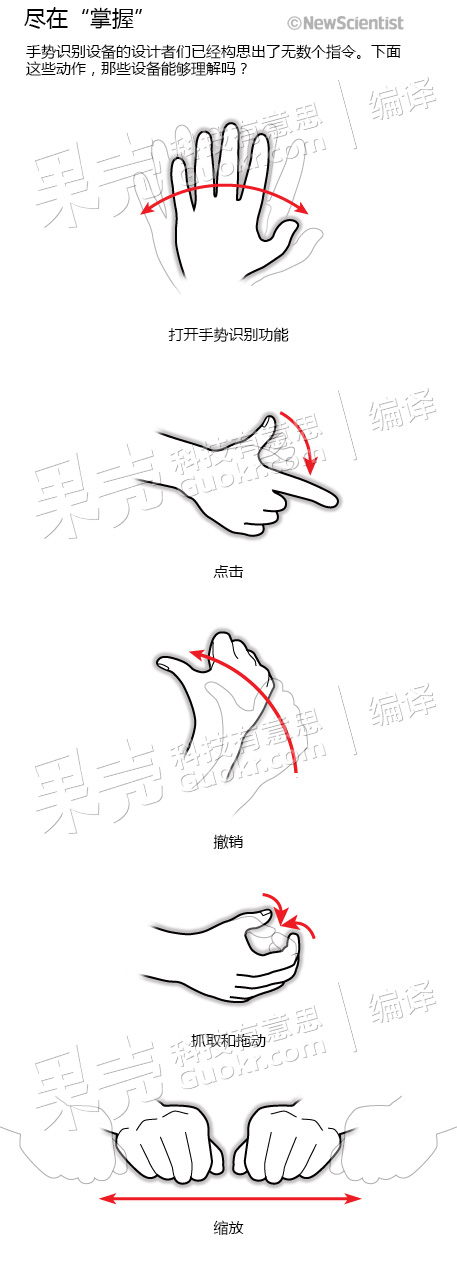

通过考察过去几年间出现在实验室里的手势识别原型技术,我们能够找到更多用于推测未来身体语言的线索。设计者已经想出了一系列手臂命令。

设计者已经构思了多种手势,用于给计算机下达指令。图片来源:《新科学家》

设计者已经构思了多种手势,用于给计算机下达指令。图片来源:《新科学家》

这些研究工作表明,用户必须非常刻意去做的新动作才是最佳的手势命令——否则他们就有无意中在屏幕上触发什么的危险。美国华盛顿州雷德蒙德市微软研究院的赫尔沃耶·平科(Hrvoje Benko)说:“我们找的是容易做出来、但在日常沟通中又并不使用的手势。”比如,有一个手势是拇指与其余四指对握,在空中做抓持状。这个动作或许可以用来拖拽屏幕上某个文件之类的对象。

其他研究者已经试验了用于改变大小或者旋转的手势。比如,在一些版本的Kinect中,分开举起的双拳可以放大屏幕,顺时针或者逆时针转动伸开的手掌,则可以旋转图片。

记忆游戏

这么多的手势当中哪些会流行起来,目前还不明确,但我们敢肯定的是,能够有效记住的手势数量是有限的。10个甚至更多的手势,可能会给我们的记忆造成抑制性的紧张。美国卡内基-梅隆大学人机交互学院的克里斯·哈里森(Chris Harrison)说:“基本手势的数量一旦超过个位数,就真的会让人头大了。”

美国马萨诸塞州剑桥市的设计师杰米·兹吉尔波姆(Jamie Zigelbaum)说,找到一种方法,让设计出来的手势词汇既能用于复杂交互,又容易记忆,这是个众所周知的挑战。2009年,兹吉尔波姆和美国麻省理工学院媒体实验室的同事,为一种名为g-speak的设备设计了一套手势。这种设备由美国洛杉矶市的Oblong工业公司生产。他们的这套手势让用户能够使用20个命令来浏览、观看和组织视频剪辑。一些动作相当直白,比如把手握成手枪的样子用来指向和选择,但还有很多动作需要把手臂拧成奇怪的姿势,招致一些批评者给出了命令太难学习的评价。

一种应对这个记忆问题的方法是,让人们在操作的过程中得到训练,而不是让他们借助图表或者视频来学习手势。平科的一个名为LightGuide的项目,利用装在天花板上的投影仪在人身上投射视觉指令,试图来解决这一问题。这套系统直接在手上显示箭头,指引它们移动到正确的位置。

或者,你可以让人们定义他们自己的手势——别管是为了关闭计算机,还是调低电视机的音量。在最近的一次试验中,英国圣安德鲁斯大学的米盖尔·纳森塔(Miguel Nacenta)及其同事,教一组人使用16个预先设定的手势,另一组人则有机会自己创造16个手部运动。第2天,自己设计手势的参与者能够多回想起44%的动作。

Leap Motion公司将推出一种设备,可以插接到大多数计算机上,追踪极为精细的手部和手指运动。图片来源:voltmagonline.com

Leap Motion公司将推出一种设备,可以插接到大多数计算机上,追踪极为精细的手部和手指运动。图片来源:voltmagonline.com

另一个影响手势词汇发展的制约因素,是我们自己的身体提出的生理要求——这些动作必须是人们能够长时间反复做的。

在以触摸屏为媒介的人机交互发展之初,研究者发现了一种被他们称为“大猩猩臂”的病痛——长时间挥舞手臂之后,人们会觉得两臂沉重。手机或是放在你腿上的平板电脑不会有这个问题,但任何需要不停伸出手臂的设备,都会很快带来酸痛——比如装在墙上的显示屏。由此看来,手势系统如果需要用手在空中做出富有表现力的动作,就很有可能造成更多“大猩猩臂”,因此更加轻微的动作很可能会成为主流。

身体的投入不仅会令手势变得累人,还会使它们不适合于某些特定场合。比如,在加拿大安大略省滑铁卢大学的亚当·弗内(Adam Fourney)2010年开展的一项试验中,授课者在两星期之内在教室里使用一个基于手势的幻灯片展示系统。他们可以利用手势前后切换幻灯片,也能与演示内容交互,比如放大图形、突出显示或者展开重点句。然而学生们说,他们更希望授课者用遥控器来切换幻灯片,而不是手势,因为手势会让人分神。不过他们倒是赞成用手势与演示内容交互,比如指向图表。弗内说,这可能是因为,这些手势与授课者日常使用的动作差别并不大。

另一个影响我们手势词汇的因素是,我们在空中挥舞双手会显得很傻。针对家庭成员如何在家中使用Kinect游戏,英国剑桥市微软研究院的理查德·哈珀(Richard Harper)和海伦娜·门蒂斯(Helena Mentis)开展了一项社会学研究,结果发现参与者笑话彼此扭曲的身体成了游戏的乐趣所在。尽管技术有过改变社会规范的先例,但是必须在工作场所之类的环境中反复做出差不多的动作,大概还是人们不太希望要做的事情。“它会迫使我们像芭蕾舞女演员那样使用自己的身体,还要伴以额外的控制、力量和规则,”哈珀说,“这会很劳神。”

所以说,流行起来的手势并不会取代键盘和鼠标(有些任务还是很难离开它们的),而是会被纳入我们用来跟计算机沟通的多层面语言当中。写论文?用键盘吧。为3D打印机建模或者整理文件?舞动手指和双手或许更合适。今天的人机交互研究者称之为“多模式”交互。平科说:“一种新的交互模式诞生时,它并不会取代其他模式,而是会扩充可能性,使新的交互成为可能。”

因此,手势计算真正的影响在于,它带来了我们以前无法使用的交流渠道。我们向他人传达意义的手段一向多种多样,包括声音、文本或者身体语言,但是直到现在,计算机对其中一些手段才不再视而不见。克莉欧老奶奶把鼠标抬离桌面的举动是有意义的。如果她能活着见到这一切,应该会对这样一个时代感到欣慰——机器终于开始理解我们的语言,而不是我们拼命去迎合它们的语言。

编译自:《新科学家》,Hands up! Do you speak digital body language?

扩展阅读

电梯有眼

在美国华盛顿州雷德蒙德市微软研究院的大厅里,有一部电梯能够像读书一样读懂你。

它的门前装有一个摄像机。有人靠近时,门就会打开——但前提是,它感知到此人打算使用它。系统处理过人们在大厅熙来攘往长达许多个小时的视频资料,学会了区分哪些人有意要使用它,哪些人仅仅是途径此地。

随着计算机开始识别更加精细的手势,它们将能够推断出更多关于我们的信息。其他一些研究者开发了软件,利用身体语言识别一个人情绪,比如开心、生气或者忧伤。这种具备“情绪智能”的机器,将能够更加准确地回应我们的需求。

所以,如果你正没精打采的坐在显示器前面,记住,计算机或许很快就会盯住你。

公然的荒谬

很难相信挥舞手臂、动动手指也会引发激烈的专利诉讼,但如果触摸屏上二维手势的发展史有所启发的话,三维手势界面也会面临同样的命运。

围绕二维手势展开的斗争是在21世纪初硅谷的一次集会之后开始的。当时微软的一名工程师吹嘘他们能用手写笔控制触屏平板电脑,触怒了苹果首席执行官斯蒂夫·乔布斯(Steve Jobs)。乔布斯命令他的工程师制造苹果公司自己的触控界面,但他坚持这种界面只能使用双手控制。他们设计出了双手指缩放、点击缩放以及滑动解锁等特定动作,苹果公司很快为这些动作申请了专利。

这一举动引发了一番手势专利的圈地运动。比如,谷歌为一种在图片中的单词下方划线的文本识别手势申请了专利,而诺基亚申请的手势专利则包括划圆或者椭圆,圆或者椭圆的大小决定了屏幕上图片放大的倍率。

将二维手势专利化的尝试最终失败了。苹果最近因为三星使用了点击缩放和滑动解锁动作而将其告上了法庭。最后,美国专利与商标局判定苹果的专利无效,因为先前的发明已经使用过这些想法。

乐观主义者也许会认为,这能防止三维手势领域出现类似的圈地运动。可惜事与愿违。微软拥有的Kinect专利中涵盖了快速挥手滚动屏幕,以及调出搜索框的手势。美国华盛顿州贝维尤尔市的高智发明公司,为一种控制电视机的方式申请了专利,内容包括抬起“平伸的手掌”以引起其注意。这家公司同样以强硬地保护其知识产权而著称。

过去几年把科技行业搅得翻天覆地的诉讼大战,看来注定要重演了,而且和往常一样,律师才会是唯一的赢家。