(文/Patrick Lin)假设有一辆无人驾驶车,正面临艰难抉择:它必须向左或向右急转弯。但如果向左转,就会撞上一辆沃尔沃越野车;如果向右转,就会撞上一辆小型车Mini Cooper。如果让你来给无人车设计算法,而且要追求一个合情合理的目标——把无人车对他人的伤害降到最小,那么你会如何选择?

如果单纯从物理学角度考虑,你应该选择撞向重量较大的车,因为它能更好地吸收撞击产生的冲击力。也就是说,你的算法应该指挥无人车撞向沃尔沃。而且去撞一辆以安全性能著称的车也是合情合理的,无论如何,无人车都应该撞向沃尔沃。

但物理学并不是我们唯一需要考虑的问题。如果我们给无人车设计这样一个“撞击优化算法”,指挥它放过哪些车、撞向哪些车,那这算法简直就是军事武器系统里的“靶向算法”了。如果无人车真的采用了这种算法,那么整个无人车产业就会被带上一条法律和道德都堪忧的道路。

虽然优化算法的本意是降低伤害,但是它确实通过系统运算做出了撞向大型车的决定。至于那些不幸被当成靶子的大型车,其驾驶员或所有者没有犯任何错误,却不得不独自承担恶果;也许他们唯一的“过错”,就在于自己太注重安全,或者确实需要一辆大型SUV才能带全家人一起出行。但他们却有可能平白无故遭受冲撞,这样真的公平吗?

虽然无人车市场上最著名的是谷歌公司的产品,但他们绝非唯一的研究组。图中是斯坦福大学2009年的自驾车,在普通汽车基础上改装而来。图片来源:Stanford

虽然无人车市场上最著名的是谷歌公司的产品,但他们绝非唯一的研究组。图中是斯坦福大学2009年的自驾车,在普通汽车基础上改装而来。图片来源:Stanford

看起来很合理的算法就这样遇到了道德挑战。如果无人车选择撞向大型车,而非小型车,那么沃尔沃和其他SUV车主当然有权愤愤不平——哪怕物理学告诉我们,这是当时情境下的最佳选择。

这个问题现实吗?

确实有许多道路交通事故无可避免,就算是无人驾驶车也不能逃脱噩运。比如一头野鹿忽然跳到车前,或者本来在旁边车道好好行驶的汽车忽然向你别过来。除非扭曲物理定律,不然事故近在眼前。但无人车或自动驾驶车也许能让撞车后果变得稍微好一点。

人类司机只能在紧急情况突发之际,凭本能快速做出反应。而无人驾驶车则受到软件控制,可以用它那“不眨眼”的监视器连续扫描周围环境。远在我们人类察觉危险之前,它就已经进行过无数次运算了。所以它们在刹那之间就能做出决定,撞向哪里才能把伤害减到最小。但是软件也要由人来写,而我们还不知道该如何处理这样的道德难题。

之所以要讨论这些极端案例,当然不是为了模拟现实世界中的真实场景。这些情景就算会成真也肯定是极其罕见的,但是它们却能暴露出正常案例里潜藏的问题。就拿刚才那个例子而言,撞击优化算法可能会表现出令人不安的歧视。也许等我们下次需要权衡两害、牺牲其一的时候,我们就该好好想一想了。

几年之前,绝大多数无人车还只是在高速公路或者野路上行驶,相对来说路况环境比较简单,也不必太过担心行人或者其他种种都市行车常会遇到的意外情况。但是谷歌最近宣布,它决定在真正的市区街道上测试它的无人驾驶车。从此以后,无人车面对的路况环境只会越来越复杂。在未来的某一天,它们势必会迎来艰难抉择:应该撞向何处?甚至撞向何人?

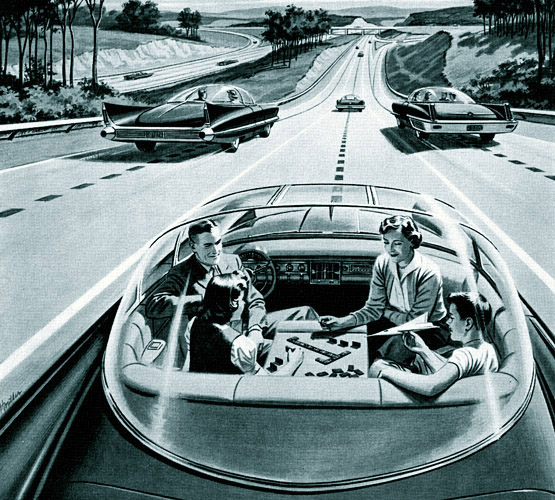

1956年人们设想的无人驾驶车。那时应该没有人意识到它可能带来的伦理问题吧。图片来源:wikipedia

1956年人们设想的无人驾驶车。那时应该没有人意识到它可能带来的伦理问题吧。图片来源:wikipedia

伦理关心的,不止是伤害

美国弗吉尼亚州交通创新与研究中心的科学家诺亚•古道尔(Noah Goodall)提出了另一种场景,更加凸显了问题的严重性:和上一个案例一样,假设一辆无人车马上就要撞到障碍物。它可以选择向左边或右边急转弯,但一边的“目标”是戴头盔的摩托车手,另一边的“目标”是不戴头盔的摩托车手。在这种情况下,该怎样为汽车编程才是正确的?

按照撞击优化算法的原则,你会编程让小车撞向那个在撞车之后生存几率最大的目标——在第一个案例中,无人车会撞向沃尔沃;在第二个案例中,它会撞向戴头盔的摩托车手。从统计数据来看,不戴头盔的车手更有可能死于车祸,好算法当然会把这概率计算在内,因为任何一家汽车制造商都不希望自己的车撞死人。

但我们很快就能发现这个选择的不公平之处——哪怕从算法角度来说十分合理。如果我们编程让无人车撞向戴头盔的摩托车手,难道不是因为他/她负责任地带了头盔而惩罚他/她?与此同时,我们却给另一个不注意安全、连头盔都没戴的摩托车手放了一条生路——在美国大多数州,不戴头盔都算违法行为。

这一歧视不单违反了道德准则,而且还不利于交通管制。随着无人车在城市街道上逐渐普及,这种撞击优化算法可能会迫使部分摩托车手为了不被当成靶子而摘下头盔。另外,在第一个案例中,消费者可能都不想让自己的车成为靶子,所以某些以安全系数高闻名的名牌车经销商就要倒霉。

道德运气的作用?

其实这些恼人的道德困境有个十分优雅的解法:不去刻意做选择不就成了。我们完全可以设计一辆无人车,让它靠随机数生成器来做某些决策。换言之,假如无人车只要选择了一个被撞的对象——无论大车或小车,戴头盔或不戴头盔——就一定会遇到伦理问题,那干嘛非要精打细算去选呢?

无人车的程序完全可以随机生成一个数字。如果得到奇数,它就拐向其中一边;如果得到偶数,它就拐向另外一边。这样一来就没人能指责无人车算法歧视了SUV、戴头盔的摩托车手或者任何东西了。

随机选择看起来也没有引入什么全新的东西:无论是好运气还是坏运气,我们都已屡见不鲜。随机选择也能更好地模仿人类司机的行为,毕竟司机需要在电光火石之间紧急做出反应,其结果完全无法预料,而且也不会遵从逻辑——因为一切都发生得太突然,我们人类没时间进行理性思考。

然而随机数字生成器也不是理想的方案,原因至少有如下几点:第一,模仿人类驾驶行为好像没有什么明显的益处,毕竟我们一开始之所以会设计无人车,不就是因为无人车能在关键时刻做出比我们人类更好的选择吗?人类犯错、分神或酒驾等等因素造成了90%以上的交通事故。仅在美国境内,每年就有超过32000人因此丧生。

第二,人类就算紧急之下做出了错误的选择,别人也容易原谅他——比如撞向容易爆炸的小车而不是更稳定的物件这种。可是无人车就没有这种特权了。程序员们拥有充足时间来完善程序,无需立即做出反应。这同样也是“预谋杀人”和“过失杀人”的区别。

人的冲动是可以原谅的,但假如这并不是冲动,而是蓄谋已久呢?就算结果完全无法区分?图片来源:Simpsons

人的冲动是可以原谅的,但假如这并不是冲动,而是蓄谋已久呢?就算结果完全无法区分?图片来源:Simpsons

第三,在可预见的未来里,找到伦理难题的“正确”解法固然很好,但这不是全部——同样重要的,是你的解法经过深思熟虑,能够为这一决策辩护,向别人展示你的道德计算。在伦理学里,思考一个问题的过程就和最终结果一样重要。而随机选择却是在逃避这一责任——不是靠深思熟虑的决策,而是靠不加思索的运气,这可能比人类反思决断之后的坏判断更糟。

我们会不会“知道得太多”?

我们也可以采取不那么极端的办法:屏蔽关键信息,让无人车无从得知两边都有谁,也就不能做出差别对待——也就是为无人车打造一个“无知之幕”。在上述两个案例中,无人车将无从得知其他车辆的品牌或型号,以及摩托车驾驶员是否配备了头盔等安全设备——虽然“车对车通讯”等现代科技能让我们轻易获取相关信息。但如果我们能为无人车打造“无知之幕”,就等于是彻底消灭了偏向选择的立足之本。

不光撞击优化算法不能使用关键信息;为了免除道德责任,也许无人车本来就不应该收集这类信息。如果无人车已经得到信息,而运用这些信息本可以拯救生命、把伤害减到最小;那么明知不为,恐怕是要被追究法律责任的。这就相当于某国家情报机关明明收集了大量恐怖袭击情报,但却没能凭此来阻止恐怖袭击一样。怎能不激起公愤。

但这种思路的问题是,无人车制造商和保险公司都希望在技术允许的范围内尽可能收集情报,这样才能了解车祸详情,或者满足其他目的——比如投放某种新型车内广告。既然收集信息的诱惑如此强烈,而且技术又允许,那么自动屏蔽关键信息,是否不切实际?

应该怎么办?

未来的无人车光靠躲避撞击是不够的,因为总有一些撞车事故因为客观原因而无法避免:来不及刹车、出现技术故障、传感器错位、天气太糟糕或者仅仅是运气不好。因此,无人车也确实需要拥有撞击优化的策略。

但要优化撞击,程序员就必须设计出损失函数算法,负责评估每个选项的预期损失,然后无人车会选择预期损失最小的那个撞上去——可能就决定了事故中谁生谁死。究其本质,无人车算法其实是个道德难题,我们需要进行审慎和透明的推理。

本文所举的例子确实罕见,但这不是问题:最罕见的例子往往会成为最重要的案例,写满各大报纸的头条。在美国,平均行驶每一亿英里会发生一次致命的交通事故。也就是说,你可能开100辈子车也没碰上过一次致命事故——但正是为了避免这种罕见事情,我们才要设计无人车啊。

再次强调,以上的场景并不是为了模拟现实环境,而是思想实验,把复杂的问题简单化,独立出几个变量分别研究。无人车困境中的变量,就是伦理领域——特别是歧视和公平问题——在无人车撞击优化算法中扮演的角色。

不过,解决道德困境并非无人车面临的最大挑战。无人车使用者和一般民众可能已经对无人车产生了错误的期望,如果他们发现情况“不对头”,一定会大为惊惧。纠正民众的错误期望,才是无人车设计者面临的更大难题。因为不管无人车在道德困境中做何选择,都不可能让所有人满意。

道德和期望的冲突,并不是少数几家公司需要面对的问题,而是所有想在这个新兴领域分一杯羹的汽车制造商和一线供货都必须直面的挑战。解决问题的第一步,也许是发起一场对无人车道德问题的公开讨论,或许能让公众和无人车设计者认清问题所在,在噩运或命运来袭之时,有能力劝服他人(同时摆脱法律诉讼)。(编辑:Ent)