(akprussia/译)涉及到机器人的人类死亡事件,其实并不是什么新鲜事。最近吸引了广泛媒体关注的一例死亡发生在德国大众汽车在鲍纳塔尔的工厂:一名员工被机械臂抓住,并砸向一块金属板。但它其实与34年前那第一起有记录的“工业机器人致死事件”惊人地相似。

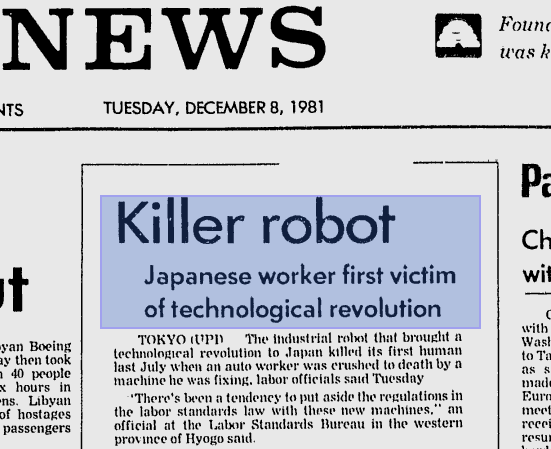

6月底引起媒体关注的工人死亡事故,与1981年日本工人发生的意外事故如出一辙。然而34年过去,“机器人杀人”、“杀手机器人”这样的描述却仍未消失。图片来源:The Deseret News

6月底引起媒体关注的工人死亡事故,与1981年日本工人发生的意外事故如出一辙。然而34年过去,“机器人杀人”、“杀手机器人”这样的描述却仍未消失。图片来源:The Deseret News

这类事件以前发生过,以后也还会再发生。尽管安全标准持续提高、人机交互中发生事故的可能性在下降,这种事件也还是会越来越频繁,因为机器人的数量在不断增加。

这意味着,对这类事故做适当的解读是十分重要的。而要做到“适当”,关键是要用准确和恰当的语言来描述它们。虽然我们感觉,把德国大众汽车工厂事故称为“机器人杀死工人”是合理的——大多数报道也的确这样做了,但是这样做却是在误导、甚至近乎不负责任。

相比之下,把表述改成“员工在机器事故中丧生”要好得多。

诚然,把报道标题改成上面这样就没那么抓人眼球了,但这正是问题的关键。事实是,不管人们从科幻小说看到并相信的机器人形象可能是什么样子,也不管机器人在遥远的将来可能做些什么,我们认识中的“真实意图”、“情感”和“目的”,现在的机器人还通通没有。而与最近那些危言耸听的说法相反,它们在近期也不会获得这些能力。

汽车工厂中的机器臂,目前并不具备目的、意图或情感这样的东西,在短期内也不会有。图片来源:Fabian Bimmer/Reuters

汽车工厂中的机器臂,目前并不具备目的、意图或情感这样的东西,在短期内也不会有。图片来源:Fabian Bimmer/Reuters

这些机器人只能以飓风(或者汽车和手枪)“杀”人的方式去致人死地。它们无法像某些动物那样杀人,更别提人类意义上的“谋杀”了。然而,大多数人看到“机器人杀死工人”时,首先涌入他们脑海的,却偏偏就是“谋杀”。

“标题党”的高昂代价

坚持要使用正确的表述并不是在咬文嚼字。“机器人杀人”这样的说法冒着很高的风险。一方面,对机器人毫无根据的恐惧感,可能会导致另一个毫无必要的“人工智能的冬天”出现——技术的开发将不再获得研究经费。这将会延迟或拒绝掉机器人所能带给工业和社会的大量好处。

但即使你对机器人带来的益处不太乐观,你也仍然应该正视这个议题。因为机器人并没有责任感,人类才应该为机器人做的事情负责。然而,随着机器人越来越普遍,人们会越来越觉得它们真的具备自主性和意图,因为它们看起来似乎有能力并且应该为自己负责。

然而机器人并没有责任,也没有负责任的能力。图片来源:shutterstock友情提供

然而机器人并没有责任,也没有负责任的能力。图片来源:shutterstock友情提供

虽然可能有一天,这些看上去理所应当的事终将成为现实,但在很长很长的一段时间内,这些“看起来是”的观点还是错的。现在,我们甚至已经试图把人机交互分成我们负责的部分和它们负责的部分,这不但引发了让机器人当替罪羊的危险,而且放过了那些本应负全责的人类设计者、配置人员和用户。

与其造“有道德的机器人”,不如有道德地造机器人

不仅那些和机器人有关的报道需要使用正确的腔调,政策制定者、销售人员以及设计机器人的研发人员也需要保持清醒的头脑。我们该问的不是“怎么制造有道德的机器人才最好”,而是“怎样才能符合道德地制造机器人”。

这种语言细节上的变化,一经采用就会导致设计层面上的大改变。比如,尝试制定机器人需要遵守的“道德法规”,就需要我们为它们提供像人类一样的常识去遵守法律——这要做要艰难得多。与其走进设计上的死胡同,我们其实可以寄望于约束机器人设计者的自我道德,一如我们在设计合乎道德的非机器人技术时所考虑的那样。

在大众汽车的事故中,一位公司发言人称“最初结论表明,人为错误才是罪魁祸首,而不是机器人的问题”。在其他报道中,则说称是人为错误而非机器人的“过失”或“责任”。这样的语言其实在暗示,在其他情况下,机器人可能会被认为该为事故负责。

如果是“机器人存在问题”,那么不管问题是错误的材料、失灵的电路板、糟糕的程序还是安装或操作协议上的不良设计,这个问题仍然会是人为的错误。

暗示机器人存在“过失”,实际上是在免除真正与需要为机器人事故负责的人类的责任。图片来源:shutterstock友情提供

暗示机器人存在“过失”,实际上是在免除真正与需要为机器人事故负责的人类的责任。图片来源:shutterstock友情提供

是的,有的工业事故是不能责备一个人或一群人的。但是我们不能因为机器人给人的印象,就免除属于它们的人类制造者的责任。

无论如何,现在还不行。

(编辑:Calo)