中科院联合阿里巴巴成立量子计算实验室。图片来源:新华网

中科院联合阿里巴巴成立量子计算实验室。图片来源:新华网

近日,中国科学院和阿里巴巴在中国科学技术大学上海研究院联合成立了“中科院-阿里巴巴量子计算实验室”。这是中国首次由科研单位引入民间资本来全资资助基础科学研究。

放眼世界,这一合作的先例来自于美国。继IBM和微软之后,Google也开展了量子计算研究,并和美国国家航天局(NASA)联合成立了量子人工智能实验室(QuAIL)。2014年,Google正式雇佣美国加利福尼亚大学圣芭芭拉分校的约翰·马丁尼斯(John Martinis)成立超导量子计算实验室,开创了私人公司全资资助量子计算实验室的先河。

阿里巴巴做为中国市值最高的互联网公司在经典信息技术上积累雄厚,同时中国科学技术大学在量子信息学研究上领先世界。在Google模式的启发下,两者一拍即合,成立了该联合实验室。

量子叠加态

量子计算为何有如此魅力,吸引互联网巨头纷纷解囊?这要从量子物理学最基本也是最奇异的特性“叠加态”(superposition)说起。在经典物理学中,物质在确定的时刻仅有确定的一个状态。量子力学则不同,物质会同时处于不同的量子态上。一个简单的例子就是双缝干涉,经典的粒子一次只能通过一个狭缝,但是量子力学的粒子一次可以同时通过多个狭缝,从而产生干涉。

传统的信息技术扎根于经典物理学,一个比特在特定时刻只有特定的状态,要么是0,要么是1,所有的计算都按照经典的物理学规律进行。量子信息扎根于量子物理学,一个量子比特(qubit)就是0和1的叠加态,可以写作:

|Φ>=a|0>+b|1>

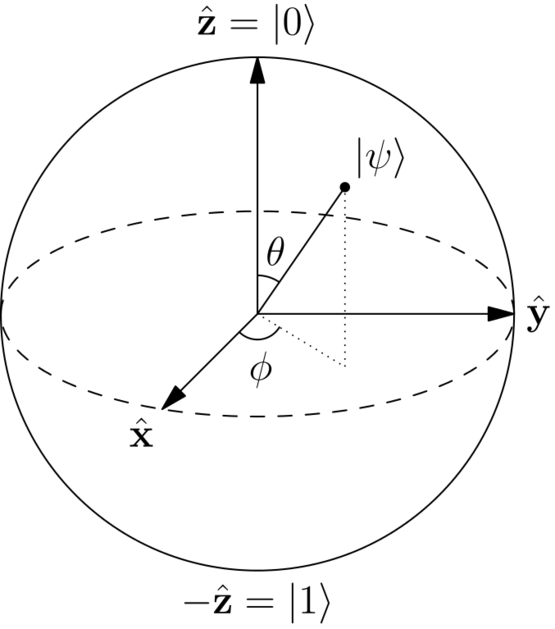

这里用Φ代表0和1的叠加(因为长得像)。|>为狄拉克符号,代表量子态。a和b是两个复数,满足关系|a|2+|b|2=1。于是一个量子比特可以用一个布洛赫球面(Bloch sphere)来表示。相比于一个经典比特只有0和1两个值,一个量子比特的值有无限个,分布在整个布洛赫球面上。

表示量子比特的布洛赫球面,球面代表了一个量子比特所有可能的取值。图片来源:维基百科

表示量子比特的布洛赫球面,球面代表了一个量子比特所有可能的取值。图片来源:维基百科

因为处于叠加态,一个量子比特同时代表|0>和|1>(只要取值不恰好是|0>或者|1>),对这个量子比特做一次操作就相当于同时对|0>和|1>都做了操作。扩展下去,比如一个10比特的数,经典计算一次运算只能处理一个数(如0001001000,0100001000,1001101101…….)。量子计算则可以处理一个10量子比特的叠加态:|ΦΦΦΦΦΦΦΦΦΦ>。这就即意味着,量子计算一次运算就可以处理210=1024个数(从0到1023被同时处理一遍)。

以此类推,量子计算的速度与量子比特数是2的指数增长关系。一个64位的量子计算机一次运算就可以同时处理264=18446744073709551616个数。如果单次运算速度达到目前民用电脑CPU的级别(1GHz),那么这个64位量子计算机的数据处理速度将是世界上最快的“天河二号”超级计算机(每秒33.86千万亿次)的545万亿倍!

量子力学叠加态赋予了量子计算机真正意义上的“并行计算”,而不像经典计算机一样只能并列更多的CPU来并行。因此在大数据处理技术强烈需求的今天,量子计算机越来越获得互联网巨头们的重视。

肖尔算法——RSA加密技术的终结者

1985年,牛津大学的物理学家戴维·德意志(David Deutsch)提出了量子图灵机的概念[1],随后贝尔实验室的彼得·肖尔(Peter Shor)于1995年提出了量子计算的第一个解决具体问题的思路,即肖尔因子分解算法[2]。

我们今天在互联网上输入的各种密码,都会用到RSA算法加密。这种技术用一个很大的数的两个质数因子生成密钥,给密码加密,从而安全地传输密码。由于这个数很大,用目前经典计算机的速度算出他的质数因子几乎是不可能的任务。

但有了量子计算机,就是另外一种情况。利用量子计算的并行性,肖尔算法可以在很短的时间内通过遍历来获得质数因子,从而破解掉密钥,使RSA加密技术不堪一击。

量子计算机会终结任何依靠计算复杂度的加密技术,但这不意味着从此我们会失去信息安全的保护。量子计算的孪生兄弟——量子通信,会从根本上解决信息传输的安全隐患。(关于量子通讯,可以参考我之前写过的科普文章。)

格罗弗算法——未来的搜索引擎

肖尔算法提出一年后的1996年,同在贝尔实验室的洛夫·格罗弗(Lov Grover)提出了格罗弗算法[3],即通过量子计算的并行能力,同时给整个数据库做变换,用最快的步骤显示出需要的数据。

量子计算的格罗弗搜索算法远远超出了经典计算机的数据搜索速度,这也是互联网巨头们对量子计算最大的关注点之一。量子信息时代的搜索引擎将植根于格罗弗算法,让我们更快捷地获取信息。

退相干——量子计算机最大的障碍

量子计算各种算法的理论已经成熟多年,但是世界上第一台量子计算机还是遥遥无期。因为在物理实现上,量子计算机需要大量的量子比特关联起来,进行量子逻辑门操作,这就不得不面对“退相干”的难题。

退相干现象来自外界环境对量子态的扰动,使量子态逐渐演化到经典的状态,失去量子叠加特性。越大的系统各种内部和外部的相互作用越多,也就越难维持量子态。退相干发生得也就越快。这就是为什么能观察粒子的叠加态,却观察不到薛定谔猫的叠加态,因为猫这么大的系统会以极快的速度发生退相干,只留下经典的死或活状态。退相干在量子和经典世界间建立了一条鸿沟。

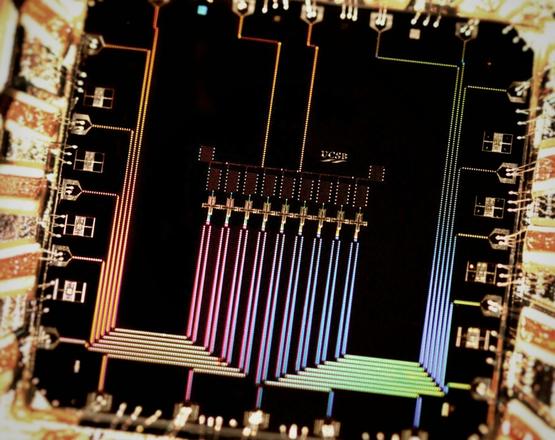

量子逻辑门的各种物理实现方案中,有的可维持较长的退相干时间,却无法做到很多的量子比特关联(如离子阱[4],核磁共振)。有的反之可以做大,但退相干时间过短(如超导电路[5],量子点)。相比之下,后者看似更有希望通过延长退相干时间取得突破,实现可用的量子计算机。

Google公司资助的超导量子计算芯片。图片来源:美国加利福尼亚大学圣芭芭拉分校

Google公司资助的超导量子计算芯片。图片来源:美国加利福尼亚大学圣芭芭拉分校

量子计算机与人工智能

英国物理学家罗杰·彭罗斯(Roger Penrose)把依靠经典计算机的人工智能称为“皇帝新脑”(即像皇帝的新衣一样)。他认为人脑不会像经典计算机那样以确定的方式处理信息,但量子测量会赋予人脑随机性,同时量子叠加态还会赋予人脑全局观(一个一个像素处理的经典计算做不到全局观),因此彭罗斯认为,人脑是一台量子计算机,并且和神经学家斯图亚特·哈默罗夫(Stuart Hameroff)给出了模型。

彭罗斯的假说很吸引人,但是麻省理工的物理学家麦克斯·特格马克(Max Tegmark)计算出,室温下彭罗斯模型的退相干时间只有10-15秒量级,远不够进行量子计算。争论仍在持续,这个假说的证据也远远不足。也许量子计算机的研究能在某个量子和经典的交汇点上给出答案,解答人类意识和智慧的起源。那样,量子计算机就会成为实现真正的人工智能的关键。

基于以上原因,量子计算机一旦实现,会成为人类历史上最伟大的科学技术成就之一。量子计算机的研究任重道远,目前仍然处于烧钱研发阶段。很多人不理解巨额投入的价值,但回想一下,我们现在手中用到的便利廉价的信息技术,都源自于上世纪五六十年代以贝尔实验室为首的科研机构长期烧钱的结果。未来我们的子孙很可能用着量子手机和智能机器人,在量子互联网上感谢着我们这个时代互联网巨头们的投入。(编辑:Steed)

参考文献

- D. Deutsch, ‘‘Quantum Theory, the Church-Turing principle and the universal quantum computer’’, Proc. R. Soc. Lond. A, 400, 97 (1985).

- P. W. Shor, “Polynomial-Time Algorithms for Prime Factorization and Discrete Logarithms on a Quantum Computer”, http://arxiv.org/pdf/quant-ph/9508027.

- L. K. Grover, “A fast quantum mechanical algorithm for database search”, http://arxiv.org/pdf/quant-ph/9605043v3.

- J. I. Cirac and P. Zoller, “Quantum computation with cold trapped ions”, Phys. Rev. Lett., 74, 4091 (1995).

- Superconducting Phase Qubits, John M. Martinis, Quantum Information Processing 8,81 (2009).