人工智能棋手 AlphaGo 先后战胜了两位顶尖围棋高手李世乭和柯洁。在这场猛烈风暴席卷了世界后,AlphaGo 宣布不再和人下棋。但它的制造者并没有因此停下脚步,AlphaGo 还在成长,今天Deepmind 又在《自然》期刊上发表了关于 AlphaGo 的新论文。

围棋中有超过10的170次方种变化,这比已知宇宙中所有的原子数量加在一起还要多。图片来源:DeepMind

围棋中有超过10的170次方种变化,这比已知宇宙中所有的原子数量加在一起还要多。图片来源:DeepMind

这篇论文中的 AlphaGo 是全新的,它不是战胜柯洁的那个最强的Master,但却是孪生兄弟。它的名字叫AlphaGo Zero,是AlphaGo 的最后一个版本。

和以前的 AlphaGo 相比,它:

- 从零开始学习,不需要任何人类的经验

- 使用更少的算力得到了更好的结果

- 发现了新的围棋定式

- 将策略网络和值网络合并

- 使用了深度残差网络

白板理论(Tabula rasa)

哲学上有种观点认为,婴儿生下来是白板一块,通过不断训练、成长获得知识和智力。

作为 AI 领域的先驱,图灵使用了这个想法。在提出了著名的“图灵测试”的论文中,他从婴儿是一块白板出发,认为只要能用机器制造一个类似小孩的 AI,然后加以训练,就能得到一个近似成人智力,甚至超越人类智力的AI。

现代科学了解到的事实并不是这样,婴儿生下来就有先天的一些能力,他们偏爱高热量的食物,饿了就会哭闹希望得到注意。这是DNA在亿万年的演化中学来的。

监督和无监督学习(Supervised & Unsupervised Learning)

计算机则完全不同,它没有亿万年的演化,因此也没有这些先天的知识,是真正的“白板一块”。监督学习和无监督学习是镜子的两面,两者都想解决同一个问题——如何让机器从零开始获得智能?

监督学习认为人要把自己的经验教给机器。拿分辨猫猫和狗狗的 AI 来说,你需要准备几千张照片,然后手把手教机器——哪张照片是猫,哪张照片是狗。机器会从中学习到分辨猫狗的细节,从毛发到眼睛到耳朵,然后举一反三得去判断一张它从没见过的照片是猫猫还是狗狗。

而无监督学习认为机器要去自己摸索,自己发现规律。人的经验或许能帮助机器掌握智能,但或许人的经验是有缺陷的,不如让机器自己发现新的,更好的规律。人的经验就放一边吧。

这段动画展示的是包含20个神经网络模块的AlphaGo Zero版本,在训练的不同阶段进行的3盘左右互搏棋局的前80步。图片来源:DeepMind

这段动画展示的是包含20个神经网络模块的AlphaGo Zero版本,在训练的不同阶段进行的3盘左右互搏棋局的前80步。图片来源:DeepMind

从无知到无敌

就像这篇新论文中讲述的那样。AlphaGo Zero 是无监督学习的产物,而它的双胞胎兄弟 Master 则用了监督学习的方法。在训练了72小时后 AlphaGo Zero 就能打败战胜李世乭的 AlphaGo Lee,相比较 AlphaGo Lee 训练了几个月。而40天后,它能以89:11的成绩,将战胜了所有人类高手的 Master 甩在后面。

AlphaGo Zero起步的时候完全不懂围棋。但是随着学习的深入,进步飞快。这个动画展示的是包含40个神经网络模块的AlphaGo Zero版本自学成才的过程。3天超过打败李世乭的AlphaGO Lee,21天超过打败柯洁的AlphaGo Master。自学 40天之后就超过了所有其他的AlphaGo版本。图片来源:DeepMind

图灵的白板假设虽然无法用在人身上,但是 AlphaGo Zero 证明了,一个白板 AI 能够被训练成超越人类的围棋高手。

强化学习(Reinforcement Learning)

强化学习是一种模仿人类学习方式的模型,它的基本方法是:要是机器得到了好的结果就能得到奖励,要是得到差的结果就得到惩罚。AlphaGo Zero 并没有像之前的兄弟姐妹一样被教育了人类的围棋知识。它只是和不同版本的自己下棋,然后用胜者的思路来训练新的版本,如此不断重复。

通过这一方法,AlphaGo Zero 完全自己摸索出了开局,收官,定式等以前人类已知的围棋知识,也摸索出了新的定势。

算法和性能

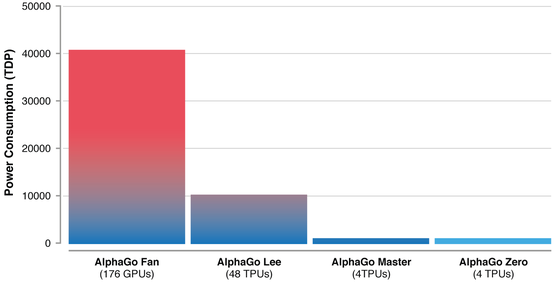

如何高效合理得利用计算资源?这是算法要解决的一个重要问题。AlphaGo Lee 使用了 48个TPU,更早版本的 AlphaGo Fan 使用了 176个 GPU,而 Master 和 AlphaGo Zero 仅仅用了 4个 TPU,也就是说一台电脑足够!

AlphaGo Zero 在 72小时内就能超越 AlphaGo Lee 也表明,优秀的算法不仅仅能降低能耗,也能极大提高效率。另外这也说明,围棋问题的复杂度并不需要动用大规模的计算能力,那是只浪费。

凭借硬件性能的不断升级和算法的不断优化,AlphaGo 后期版本的运算效率明显优于最初的版本。图片来源:DeepMind

AlphaGo Zero 的算法有两处核心优化:将策略网络(计算下子的概率)和值网络(计算胜率)这两个神经网络结合,其实在第一篇 AlphaGo 的论文中,这两种网络已经使用了类似的架构。另外,引入了深度残差网络(DeepResidual Network),比起之前的多层神经网络效果更好。

Deepmind 的历程

DeepMind创始人之一,德米斯•哈萨比斯(DemisHassabis)

DeepMind创始人之一,德米斯•哈萨比斯(DemisHassabis)

这不是 Deepmind 第一次在《自然》期刊上投稿,他们还发表过《利用深度神经网络和搜索树的围棋AI》和《AI 电脑游戏大师》等几篇论文。

我们可以从中一窥 Deepmind 的思路,他们寻找人类还没有理解原理的游戏,游戏比起现实世界的问题要简单很多。然后他们选择了两条路,一条道路是优化算法,另外一条道路是让机器不受人类先入为主经验的影响。

这两条路交汇的终点,是那个超人的 AI。

DeepMind创始人之一,大卫·席尔瓦(David Silver)

DeepMind创始人之一,大卫·席尔瓦(David Silver)

结语

这是AlphaGo 的终曲,也是一个全新的开始,相关技术将被用于造福人类,帮助科学家认识蛋白质折叠,制造出治疗疑难杂症的药物,开发新材料,以制造以出更好的产品。(编辑:明天)