安排行程、外卖点餐或者搜索,现在我们大概已经可以信任Siri或者Alexa这样的智能语音助手,帮我们处理一些生活中的小事。有的时候,我们甚至会产生“它(她)们是真正存在的智能”的感觉——随着技术的发展,它们仿佛已经能够理解对话中的微妙之处,并且拥有一些小情绪。

比如,2012年Siri刚诞生不久的时候,你跟Siri说,“我受伤了,叫救护车”(I’m hurt, call me an ambulance),Siri会说“好的,从现在开始,我就叫你‘救护车’吧。”(OK, now I’ll call you “An Ambulance”)。然而,最近的新闻里却说,一位住在澳大利亚的母亲早起看到女儿忽然窒息,情急之下她对着Siri大喊叫救护车,Siri果然帮她拨通了急救热线,救了她女儿一命。

是Siri理解人类对话的能力增强了么?并不是。是程序员看到了社会上的争议,把“叫救护车”这个特例写进了更新。机器所表露出来的所谓“情感”也是这样的道理——比如,程序员把各种各样的答案写在了“我爱你”的预设答案中,以回应世界各地的人对于Siri的“调戏”。

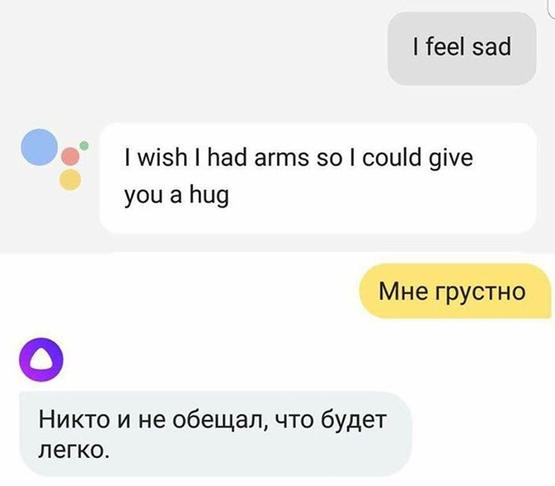

2017年9月的一件小事,或许更能体现人工智能情感的微妙之处:来自美国的谷歌智能助手,以及来自俄罗斯社交网络巨头Yandex开发的Alis,对一句同样的话表达出的不同情绪反应,在网上激起了不少讨论。你如果对谷歌智能助手说一句,“我好伤心”(I’m Sad),助手会回答说:“我希望我有手臂,这样就可以抱抱你了”,标准的暖心安慰;而俄罗斯的Alisa则会说,“没人说过人生会一帆风顺”,仿佛一盆傲娇的冷水,又感觉在默默地鼓励。

我们向智能助手倾诉,向它表白,和它闲聊,一定有我们自己对回应的期望。而AI的“理解力”,与我们的文化模式、对情绪的解构,乃至感情的数据化、标准化表达息息相关,也是由制造AI的人所决定的。

现在机器学习的基本原理,就是从大量的数据里提取各种各样的模式,用算法模型训练它给出预测,并不断提高精准度。现在的深度神经网络已经可以做到“无监督的学习”,自行调试数据权重,来更好地拟合实际的数据模式。它拾取的是数据中的“相关性”,所以给出的结果,也是“从数据上最可能的”结果,而不是“应该的”结果。

同样的,对于机器情感的训练,也是基于大量数据的输入来实现的,我们平日里所表达出来的东西,变成了训练机器的语料。所以,不管是谷歌助手,还是Alisa,反映的都是我们平日交流里的一些情感模式(emotional regime),不同的人群有着不同的交流模式,这些模式是能够被机器识别的。

Google Home。题图来源:Google

Google Home。题图来源:Google

诞生于硅谷的谷歌助手,言谈中就像是一个加州裤衩小伙或者凉拖姑娘,挂着美国人特有的那种预设笑容,一旦遇到别人心情低落就赶紧去劝别人开心一点儿。用社会学家伊娃·伊洛兹(Eva Illouz)的话来说,这种无时无刻不用积极的情绪要求自己的情感模式,叫“情感资本主义”。这种模式认为,情感是可以自己控制的,保持积极的心态是符合自我利益的;而人与人之间的关系是一种利益上的投资-回报,是对情感方面“需求”的回应;这个利益,就是个人的“快乐”和“幸福”。所以,谷歌助手想要抱抱你,是对负面情感的一种积极回应;创造它的人也相信,这种对话模式符合对情感交往的期待。

至于Alisa,则是被俄语语料训练出来的智能。它(她?)展现了一个合格的俄国女性所需要的素质:能捆住狂奔的野马,能冲入燃烧的房子,也能理解世界的无情。社会学家茱莉亚·莱纳尔(Julia Lerner)把它描述为“情感社会主义”(这里的社会主义的应该理解为带有苏联色彩的)——承认悲剧无法避免,与其给予拥抱,不如献上铁拳。在俄罗斯的文学和社会传统里,快乐并不是那么紧要的事情,人在逆境下生存的能力是最重要的。

Alisa的开发者对此是有认识的。“Alisa不能太甜太软,我们生活的社会,人们的思维模式跟西方不一样,”Yandex负责Alisa的产品经理说。“人们欣赏有点讽刺、有点黑色幽默,不太有攻击性但也别太软的性格。”

Alisa。题图来源:Yandex

Alisa。题图来源:Yandex

问题也就在这里:究竟谁开发出来的人工智能,能够真实地反映我们交往中的情感,以及那些不可言说的微妙之处?要用哪些语料、什么样的文化模式去训练AI?但现实是,大部分的人工智能都诞生于美国湾区、白人男性之手。

而我们话语中的偏见、阴暗之处,是否也会造成不可预测的后果呢?Alisa的开发团队做了很多工作,保证Alisa不会说出太过分的话。这非常困难——政治不太正确的俄国人提供的大量的语料中,存在一些他们也无法堵上的漏洞。比如,有人曾经问Alisa,“丈夫可以打妻子吗?”Alisa回答说“当然可以”。此事在网上闹得沸沸扬扬,Alisa的团队不得不承诺,将对她的语言进行更进一步的优化。

更重要的是,机器与人类的情感交流,会不会固化现有的情感模式——不管是“情感资本主义”,还是“情感社会主义”,这些真的能够切实地增进每个人的福利吗?

机器对于情感理解的需求,正在与日俱增,越来越多的人向电子世界寻求情感上的帮助。根据亚马逊的统计,和智能助理Alexa的谈话中,有大概一半的人不是要Alexa具体做个什么,而是各式各样的闲聊——今天干了啥,冷笑话,或者人生意义。苹果公司在2017年也宣称将加强Siri对于“情感”的支持,“帮助人们过一个更加健康的生活”。有研究表明,人们更愿意与一个聊天机器人吐露心声,人们面对机器表露出更加强烈的悲伤,以及更不在意诉说秘密。

而现在,协助“情绪管理”的一些智能应用,已经开始投入商业使用了,比如一个叫Woebot的服务,宣称能够监测你的情绪波动,并且用各种交互手段“让你感觉更好”;还有一个叫做Mend的软件,用交谈来帮助失恋的人更快地恢复正常。这些从某种意义上都是有用的——人工智能可以处理并探测到你语言和行为当中有问题的部分,并通过互动来帮助人们纾解情绪中的问题,就像心理咨询师一样。

Woebot开发团队。图片来源:吴恩达

Woebot开发团队。图片来源:吴恩达

然而,这些情绪管理,却是所谓“情感资本主义”的体现——开心和快乐是人们想要追求的利益,需要用一些行动去换取;而且,开心和悲伤的程度可以被衡量,努力的过程也可以被“管理”起来,所有的一切都在帮助自己变得更积极、更向上。我们对于自己情绪的感受和理解,是否也逐渐变得跟机器一般?甚至走得更远一些,当我们的一举一动都纳入机器的计算,让人工智能来为我们“纠偏”,我们还有所谓的情绪和情感吗?

“跟Alisa聊天就像跟出租司机搭话一样。”一个俄罗斯的用户这样描述。或许出租司机知道能用条件反射般的只言片语填充车里的尴尬空气,这样的交谈能让加班到凌晨的你感觉好一些。但那是我们想要的情感吗?(编辑:Ent,EON)

参考文献:

- Aeon, The quantified heart

- Medium, How will your bot know it’s morning?